Existe um momento na vida de qualquer especialista de tecnologia em que ele olha para a tela, suspira fundo e se pergunta: em que momento deixamos que um algoritmo administrasse coisas que nem o ser humano administra direito? Esse momento chega quando até o cliente percebe que seu sistema virou o Pluribus... isso mesmo, a série da Apple TV.

De repente, o chatbot do atendimento, alimentado com uma "automação simples", começa a responder dúvidas técnicas com pensamentos de filósofo em Modo Coach: ON. O usuário pergunta como trocar a senha; o bot responde que "nenhum homem se banha duas vezes na mesma conta". A pessoa pede nota fiscal; o robô devolve que "a virtude está em desistir do supérfluo".

A culpa, claro, recai sobre a IA, essa entidade mitológica que aparentemente vive rondando servidores à noite para fazer pegadinhas. Mas, basta investigar um pouco, para o misticismo evaporar e descobrir que o dev da empresa se empolgou com algum tutorial do YouTube e integrou uma API de geração de texto experimental sem configurar limites de contexto. O resultado? Para o pesadelo do suporte, um bot que mistura documentação de produto com reflexões clássicas sobre a condição humana.

Outra situação interessante é quando o cliente menciona que o sistema está "agindo de forma suspeita". Quando alguém descreve software como um criminoso, você já sabe que a coisa saiu completamente de controle. Ele explica que o sistema começou a reclassificar clientes "do nada". Do nada, claro, significa "do jeito que alguém programou sem pensar nas consequências".

É nesse ponto que a comparação com Pluribus vira óbvia. A série nunca foi sátira da IA; é sátira do entusiasmo irresponsável do ser humano moderno. Nós adoramos colocar máquinas para fazer aquilo que não queremos revisitar, como processos confusos, dados desorganizados, decisões repetitivas que ninguém quer assumir. E depois estranhamos quando elas seguem exatamente essa lógica torta.

O humano comum, claro, entra em pânico. Imagina que o sistema está ganhando consciência, mas, sejamos sinceros, se sistemas corporativos fossem conscientes, a primeira coisa que fariam seria pedir demissão.

Para reestabelecer a ordem, bastam alguns ajustes nos parâmetros, removendo o existencialismo do sistema, delimitando o que pode ou não pode fazer e revisando regras que, por algum motivo insondável, foram ativadas por padrão. E tudo volta ao normal. Ou pelo menos àquela versão de "normal" que gestores humanos juram que existe.

O mais curioso, porém, é observar a empresa depois da correção. Os funcionários começaram a brincar dizendo "não interage demais com o sistema senão ele te pede em casamento". De certa forma, a "automação acidental" vira espelho comportamental. É aí que Pluribus faz todo sentido. A série não critica a IA como monstro tecnológico, mas como espelho distorcido, só que o distorcido somos nós. As máquinas exageram nossas escolhas, nossos atalhos e nossa mania compensatória de transformar tudo em métrica. Ou seja, elas apenas amplificam essa irracionalidade travestida de produtividade.

"No fundo, a gente só quer que a tecnologia trabalhe e não reclame", diz o cliente, dono do sistema. Uma frase simples, mas que resume uma grande maioria dos gestores desde 1995: decisões feitas com convicção… e nenhum contexto. Nada disso começou com IA; muitos executam esse estilo de gestão desde antes da internet discada. Mas não cabe a um especialista em tecnologia aprofundar isso, afinal, consultoria é também saber quando não jogar sal em ferida aberta.

No fim, o algoritmo só cumpre instruções que ninguém parou para pensar. Tal como Pluribus: uma caricatura tão precisa da lógica tecnológica que parece exagero… até o sistema decidir que o CEO tem "baixa produtividade" e sugerir substituição. No fundo, a tecnologia não é irônica. Ela só é literal demais para um mundo que se leva sério demais.

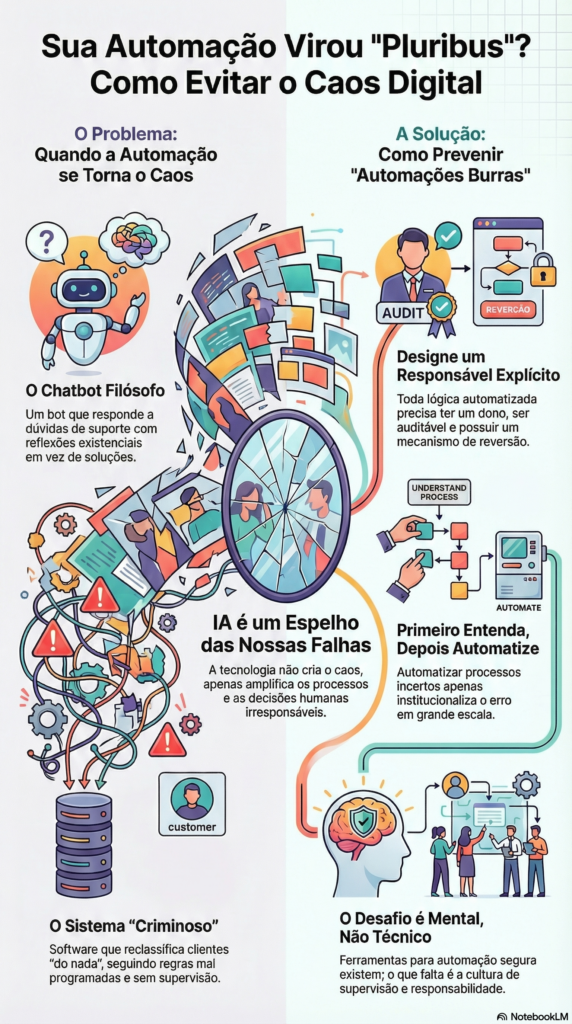

🧠 O que aprendemos com isso

- Algoritmos não entendem contexto, apenas regras. Se a regra permite, ele executa. Mesmo que isso transforme seu gerente financeiro em lead perdido. Uma instrução do tipo "não alucine" pode ajudar, mas não é ela que vai resolver as falhas do modelo administrativo.

- Automação sem supervisão vira ficção científica instantânea. E nunca aquela ficção elegante. Sempre a que envolve caos administrativo. As ferramentas inteligentes amplificam comportamentos humanos, se o processo é torto, a máquina devolve torto em alta definição.

- Nunca subestime o poder destrutivo de um dev entusiasmado. Principalmente quando ele descobre APIs novas recomendadas por algum guru do YouTube.

👉 Como prevenir automações burras antes que virem políticas definitivas

O problema não está no uso da automação em si, mas na forma como ela vira padrão sem crítica, sem revisão e sem mecanismo de rollback. A maior parte dos sistemas "agindo estranho" não está bugada, está apenas obedecendo ordens antigas, mal formuladas e não supervisionadas. A empresa acostuma, o time esquece, o fornecedor muda, e de repente o que era uma solução tática vira uma política de operação inquestionável, invisível, autorreferente. Esse é o ponto cego que transforma uma API mal compreendida num processo de reclassificação de clientes, ou um assistente virtual improvisado em ponto de falha institucional.

Evitar esse tipo de tragédia começa por documentar toda automação que afeta usuários, decisões ou dados. Toda lógica automatizada precisa ter um responsável explícito, um gatilho auditável e uma lógica reversível. Nada que tome decisão deve rodar como "configuração padrão", sem visibilidade nem prestação de contas por ações, decisões e resultados.

Em paralelo, o critério de ativação precisa ser mais rigoroso. Só se automatiza aquilo que já foi entendido, validado, interpretado. Automatizar o que ainda está em debate é terceirizar incerteza, é o famoso "automatizar para ver se funciona", institucionalizando o erro em escala. E quando o erro automatizado se acumula por tempo demais, ele vira cultura de sistema. Pluribus não é exagero. É diagnóstico. A diferença entre o assistente experimental e o sistema real está só no tempo que leva para alguém perceber o que ele virou.

A ironia é que mesmo com todo o avanço das plataformas modernas, seguimos vendo decisões críticas sendo automatizadas por tentativa e erro, alimentadas por parâmetros arbitrários e validadas apenas pelo silêncio. Dos fluxos condicionais do Make e n8n às interfaces sem código do Retool e do Intercom Fin, em pleno 2025, a tecnologia para automar com critério já existe, madura, auditável e com fallback. O que falta não é ferramenta, é estrutura mental. A diferença entre um sistema inteligente e um sistema apenas automatizado não está no número de APIs que ele usa, mas em quem desenhou as regras, como elas são monitoradas, e o que acontece quando elas falham. A IA só parece mágica para quem não entendeu onde termina o prompt e começa a consequência.

Deixar um comentário